Что делает ИИ с неудобными запросами

Как я поняла, что ИИ может идеально понимать экспертный запрос и всё равно аккуратно сворачивать его обратно к своей норме, если вы пытаетесь оспорить сам канон.

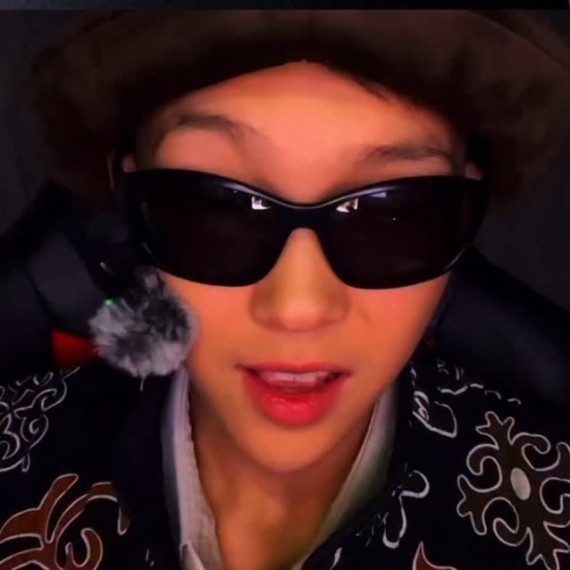

На фото образ, который я собирала вместе с ИИ, стилизуя свой гардероб в логике Йодзи Ямамото. Казалось бы, обычная история про одежду. На самом деле — очень показательный учебный кейс.

Знакомо?

Ты формулируешь запрос своей нейросети, пишешь промпт — точно, профессионально, с контекстом.

Ты точно знаешь, чего хочешь.

А на выходе снова и снова получаешь... ну, такое... «нормально», «прилично», «так, как обычно, как принято...». Без вдохновения, да и, если честно, думала, что ответ будет иной.

И в этот момент обычно думают одно из трёх:

— «Наверное, я плохо объяснила».

— «Наверное, ИИ меня не понял».

— «Наверное, у меня недостаточно экспертизы, чтобы запросить по-настоящему

сложное».

Спойлер: часто дело не в этом.

В моём случае ИИ отлично понимал, кто такой Йодзи Ямамото — на уровне терминов, описаний, логики. Но генерируя иллюстрацию снова и снова аккуратно «исправлял» странность образа до более привычной эстетики. Не спорил. Просто сглаживал.

Есть ещё одна причина, гораздо менее очевидная — и она особенно бьёт по тем, кто работает с ИИ на экспертном уровне: в методологии, образовании, аналитике, дизайне, концептах, стратегиях.

Это был не сбой, не непонимание и не «плохой промпт». И когда я наконец поняла, что именно происходит, это оказалось напрямую связано с тем, как ИИ обращается с нестандартными, «неудобными» замыслами.

👉 Разбираю этот эффект подробно и показываю, как с ним работать — в Telegram-канале «Мать ученья».